ちょっと久々に、完全ワイヤレスイヤホン・WF-1000XM4のお話。実に心地よい音と強力なノイズキャンセリング性能だけに留まらず、実に多彩な機能を持つ製品なのですが、音声アシスタントへの対応も、その中のひとつです。

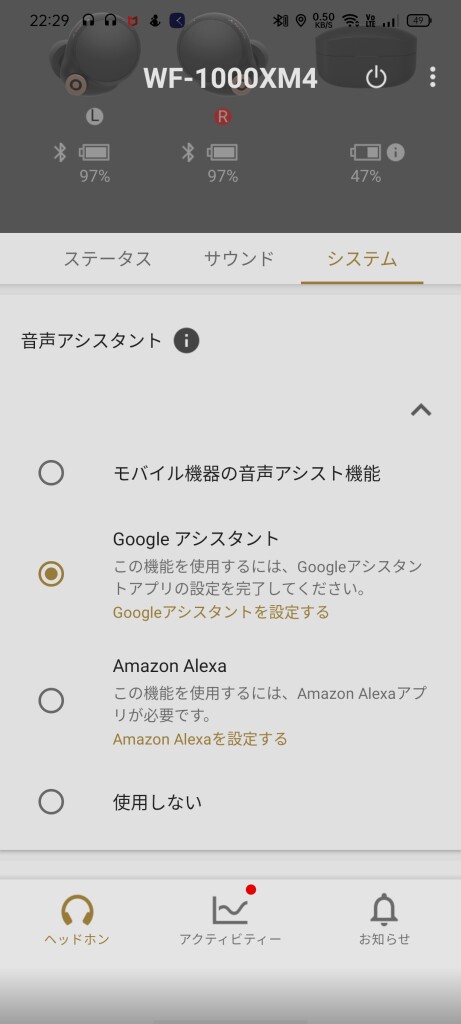

WF-1000XM4としては、スマートフォンアプリ・Sony | Headphones Connectとの連携で、Google アシスタントとAmazon Alexaに対応しています。どちらの場合も、別途それぞれのアプリをインストールしたり、設定したりする必要があります。

また、単にヘッドセットとしてマイクから取り込んだ音声を送ることで、スマートフォン等のデバイス側の音声アシスト機能を呼び出すこともできます。Android スマートフォンの場合は標準がGoogle アプリ(≒Google アシスタント)ということになるので、大して変わらない?という話になりますが、iPhoneの場合は「Siriを呼び出したい」という需要がありそうです。

実際の呼び出し方としては、まず本体のタッチセンサーを使う方法があります。タッチセンサーの機能は左右それぞれで「外音コントロール」「再生コントロール」「音量コントロール」のいずれかを選択するようになっていて、再生コントロールの中に「押し続けると音声入力」というのがあります。

この設定方法がなかなか悩ましく、3つのグループのうち2つを選ぶことになるので、残りひとつのグループの機能が割り当てられないことになります。例えば、曲送りと音量調整を使いたい!と思うと、ノイズキャンセリングの操作ができません。音声入力をタッチセンサーで起動したい場合には、ノイズキャンセリングか音量調整のどちらかが犠牲になります。左右それぞれで、タッチの回数や長押しそれぞれに別機能が割り当てられると、もっと便利なのですが…。

もっとも、音声入力の場合は「音声そのもので起動する」というもうひとつの方法があります。それぞれの音声アシスタントアプリで初期設定を済ませておけば、「OK, Google」や「アレクサ」の起動ワードを受け付けてくれます。これなら、タッチセンサーの機能から「再生コントロール」を外す選択が出てきます。「おっけーぐーぐる、次の曲かけて」などができますからね。ただし、音声での起動は「モバイル機器の音声アシスタントを使用」のモードでは使えません。

タッチセンサーから音声アシスタントを起動する場合、タッチセンサーに触れ続けると受付開始の通知音が鳴り、音声入力を認識するようになります。触れ続けている間は音声入力を受け付けて、指を離すと入力終了となります。音声で起動する場合は、キーワードをシステムが認識すると通知音が鳴り、音声入力の認識が始まります。

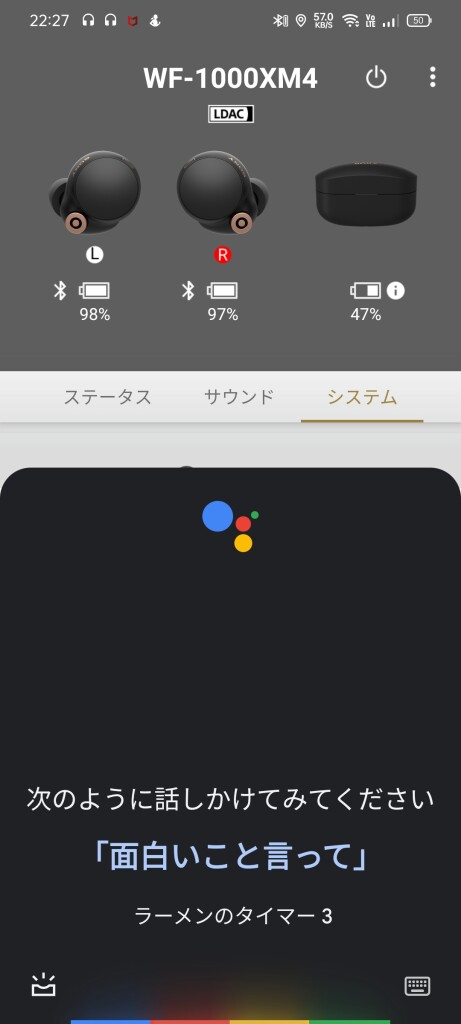

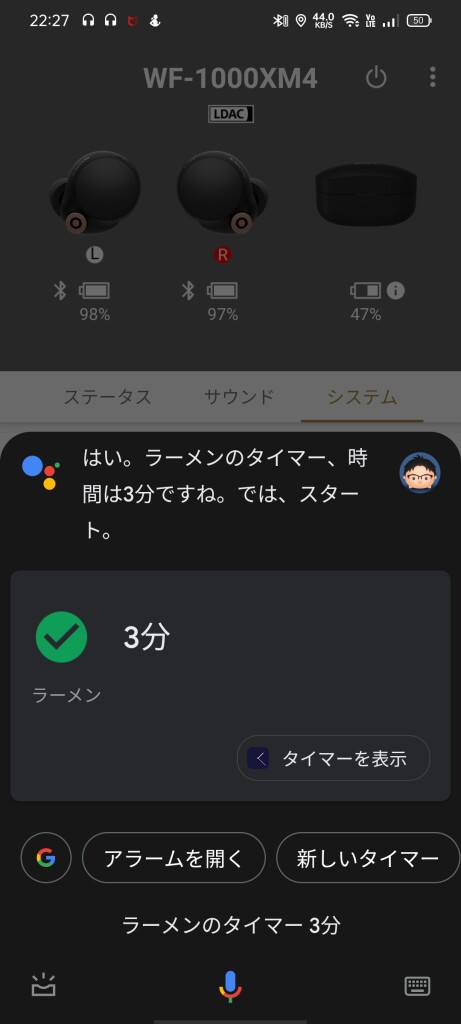

Headphones Connectアプリの設定を「モバイル機器の音声アシスタントを使用」にしておくと、呼び出したときに本体側の画面でアシスタントが起動し、そこに入力結果が表示されます。Headphones Connectアプリが(というよりWF-1000XM4が、と言うべきか)直接音声アシスタントを呼び出すときは、この画面は表示されず、基本的に音声ベースでの対応になります。画面描画の処理が要らないおかげか、反応はこの方がちょっと早いような気がします。

音声入力の認識自体は各アプリ・サービスの能力次第…ということにもなるわけですが、スマホ本体のマイクやecho dotからの入力と同様に反応を返してくれます。少なくとも、WF-1000XM4のマイクから得られる音声は十分音声入力に耐える品質だ…ということになりそうです。もっとも、既にWeb会議などで相手に話が伝わる実力は確認済ですが。

先に例示した「次の曲かけて」などと同じくらい便利なのが、「コレなんて曲?」。スマホを取り出して画面を見なくても、今演奏されている曲名・アーティスト名を教えてくれます。Google アシスタントでもAmazon Music アプリの曲名をちゃんと返してきます。今どきはいろいろ変わった読み方をするアーティストもいますが、ほとんど読み間違えません。milet(みれい)、Aimer(えめ)(ふたりともWF-1000XM4のCMでお馴染みですが)あたりもOK。このあたりはさすがに膨大なデータベースがモノを言います。大したものです。

ただ、音声入力を認識してもらうためには、ささやき声レベルでは難しく、小声ながらもかなり明瞭な発声が求められます。外出先など人の多いところで独り言(に見えますからね、どうしても)を喋るのが恥ずかしい!と感じてしまう人には、心理的なハードルが高いかも知れません。

コメントを残す